Paramanu-Ganita: un modelo matemático que supera a LLaMa, Falcon y PaLM

Prueba de ello es el auge de Paramanu-Ganita, el modelo matemático que está demostrando ser más robusto y versátil que LLaMa, Falcon y PaLM.

En el panorama en constante evolución de la inteligencia artificial, la búsqueda de modelos lingüísticos más potentes y eficaces ha sido una fuerza motriz. Paramanu-Ganita, un innovador modelo matemático, ha cambiado las reglas del juego y ha superado las capacidades de modelos tan conocidos como LLaMa, Falcon y PaLM.

Desarrollado por un equipo de investigadores e ingenieros de renombre, Paramanu-Ganita es un testimonio del poder de la colaboración interdisciplinar. Al combinar la mecánica cuántica y los principios matemáticos indios, el modelo alcanza una precisión, velocidad y versatilidad notables, aptas para diversas aplicaciones como la generación de lenguajes y la resolución de problemas.

Ve al grano 🤓 👇

7 mejores generadores de citas de IA par...

7 mejores generadores de citas de IA par...Paramanu-Ganita

Paramanu-Ganita es un novedoso modelo de lenguaje diseñado específicamente para el razonamiento matemático y la resolución de problemas. Desarrollado por los investigadores Mitodru Niyogi y Arnab Bhattacharya, Paramanu Ganita es una IA especializada entrenada en diversos datos matemáticos. A pesar de su tamaño compacto de 208 millones de parámetros, supera a modelos más grandes en pruebas de referencia matemáticas.

El nombre "Paramanu Ganita" se traduce como "matemáticas atómicas" en sánscrito, lo que refleja la precisión del modelo y su enfoque fundacional de los problemas matemáticos. Mediante un descodificador autorregresivo (AR), genera secuencias de texto utilizando la lógica matemática, lo que supone un importante avance de la IA.

Principios de Paramanu-Ganita

Este modelo, a pesar de ser significativamente más pequeño que otros modelos lingüísticos, ha demostrado un rendimiento superior en tareas de razonamiento cuantitativo. Los principios de Paramanu-Ganita incluyen

- Soluciones específicas de dominio: Paramanu-Ganita cuestiona la necesidad de modelos lingüísticos más grandes demostrando que las soluciones más pequeñas y específicas de un dominio pueden ser muy eficaces en la resolución de problemas matemáticos.

- Partículas subatómicas y estructura atómica: Paramanu-Ganita explora los átomos y sus interacciones subatómicas, ofreciendo una visión de la estructura atómica y el movimiento de los electrones.

- Transformaciones atómicas: El modelo analiza transformaciones atómicas como la fisión, la fusión y la radiactividad, mostrando un profundo conocimiento de estos procesos.

- Proceso de entrenamiento: Se entrenó utilizando un decodificador autorregresivo (AR) y alcanzó sus objetivos con sólo 146 horas de entrenamiento en una GPU Nvidia A100.

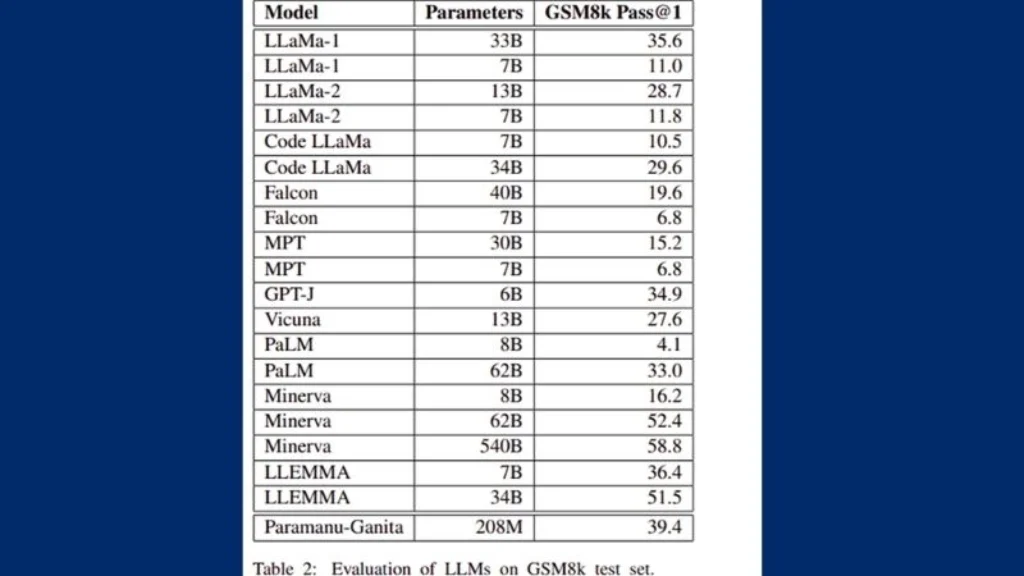

- Rendimiento: En la prueba GSM8k de razonamiento matemático, Paramanu-Ganita obtuvo resultados impresionantes, superando a modelos más grandes con un margen significativo en precisión Pass@1.

- Modelización matemática: Paramanu-Ganita utiliza técnicas matemáticas avanzadas, como la geometría y el álgebra, para modelar y analizar el comportamiento de los átomos y las partículas subatómicas. Demuestra una gran capacidad de razonamiento matemático sin necesidad de una enorme potencia de cálculo.

Comparación con otros LLM como LLaMa, Falcon y PaLM

Paramanu-Ganita se distingue entre los grandes modelos lingüísticos (LLM) por su enfoque en el razonamiento matemático. He aquí una comparación con otros LLM como LLaMa, Falcon y PaLM:

Undress app hackeado apk

Undress app hackeado apk- Tamaño y eficiencia: A pesar de tener sólo 208 millones de parámetros, Paramanu Ganita supera a modelos más grandes como LLaMa, Falcon y PaLM en pruebas matemáticas, lo que demuestra que la eficiencia puede venir en paquetes más pequeños.

- Formación y rentabilidad: Requiere mucho menos tiempo de formación, lo que lo hace rentable, y aun así supera el rendimiento incluso de los LLM más grandes en tareas matemáticas específicas.

- Rendimiento: A pesar de ser más pequeño, Paramanu Ganita superó a grandes LLM como PaLM 62B en un 6,4%, Falcon 40B en un 19,8%, LLaMa-1 33B en un 3,8% y Vicuna 13B en un 11,8%. Esto demuestra que el razonamiento no se limita a modelos con muchos parámetros.

Evolución futura de Paramanu-Ganita

Los futuros avances de Paramanu Ganita, un modelo matemático, son bastante prometedores. He aquí algunos puntos clave que ponen de relieve sus posibles avances:

- Expansión del modelo: Los creadores de Paramanu-Ganita sólo lo han entrenado con una parte de todo su corpus matemático, lo que indica que hay potencial para mejorar aún más sus capacidades entrenando con el conjunto de datos completo.

- Adaptación a dominios específicos: El éxito de Paramanu-Ganita sugiere que podría adaptarse a dominios matemáticos específicos, como el álgebra, el cálculo o la estadística, para proporcionar resultados aún más especializados y precisos.

- Integración educativa: Existe potencial para que Paramanu-Ganita se integre en plataformas educativas, proporcionando a estudiantes y educadores una potente herramienta para la enseñanza y el aprendizaje de las matemáticas.

- Colaboración en investigación: El modelo podría utilizarse en la investigación colaborativa, sobre todo en campos que requieren un cálculo matemático pesado, para acelerar los descubrimientos y las innovaciones.

- Aplicaciones industriales: Las industrias que dependen de la modelización matemática, como las finanzas, la ingeniería y la tecnología, podrían beneficiarse de la eficacia y precisión de Paramanu-Ganita.

- Sinergia de modelos lingüísticos: Dado el éxito de Gyan AI con Paramanu, una serie de modelos lingüísticos adaptados a diez lenguas indias, puede haber oportunidades de combinar modelos lingüísticos y matemáticos para obtener soluciones de IA más completas.

Preguntas frecuentes

¿Puede utilizarse Paramanu Ganita para tareas lingüísticas generales?

Aunque Paramanu Ganita está especializado en matemáticas, no se ha mencionado explícitamente su rendimiento en tareas lingüísticas generales.

¿Cuál es el potencial futuro de Paramanu Ganita?

Los desarrolladores sólo han entrenado a Paramanu-Ganita con una parte de todo su corpus matemático, lo que indica que hay potencial para seguir explorando las capacidades del modelo.

¿Cómo es el tamaño de Paramanu Ganita en comparación con otros modelos?

Paramanu-Ganita es 35 veces más pequeño que los modelos lingüísticos de 7B parámetros, pero aun así los supera en razonamiento matemático.

Adobe Podcast AI - Características y Us...

Adobe Podcast AI - Características y Us...¿Qué implicaciones tiene el éxito de Paramanu-Ganita para el campo de la IA?

El éxito de Paramanu-Ganita sugiere que pueden crearse potentes modelos lingüísticos específicos de un dominio sin necesidad de modelos gigantescos ni grandes recursos informáticos.

Conclusión

La aparición de Paramanu-Ganita marca un hito importante en el campo de la inteligencia artificial y el procesamiento del lenguaje natural. Su capacidad para superar a modelos establecidos como LLaMa, Falcon y PaLM demuestra el potencial de avances revolucionarios cuando se combinan de forma innovadora metodologías tradicionales y de vanguardia.

El impacto de Paramanu-Ganita va más allá del mundo académico, ya que ha transformado industrias, impulsado avances tecnológicos y abierto las fronteras de la IA. De cara al futuro, la fusión de computación cuántica, principios matemáticos ancestrales y técnicas modernas de aprendizaje profundo en este modelo allana el camino para una nueva era de innovación en IA.

Calculadora de Keeper AI: Prueba estánd...

Calculadora de Keeper AI: Prueba estánd...Si quieres conocer otros artículos parecidos a Paramanu-Ganita: un modelo matemático que supera a LLaMa, Falcon y PaLM puedes visitar la categoría ChatBot.

Deja una respuesta

Contenido relacionado